Реферат: Количество информации

При частичном снятии неопределенности, полученное количество информации и оставшаяся неснятой неопределенность составляют в сумме исходную неопределенность. Ht + It = H.

По этой причине, формулы, которые будут представлены ниже для расчета энтропии H являются и формулами для расчета количества информации I, т.е. когда речь идет о полном снятии неопределенности, H в них может заменяться на I.

3.Формула Шеннона

В общем случае, энтропия H и количество получаемой в результате снятия неопределенности информации I зависят от исходного количества рассматриваемых вариантов N и априорных вероятностей реализации каждого из них P: {p0 , p1 , …pN -1 }, т.е. H=F(N, P). Расчет энтропии в этом случае производится по формуле Шеннона, предложенной им в 1948 году в статье "Математическая теория связи".

В частном случае, когда все варианты равновероятны, остается зависимость только от количества рассматриваемых вариантов, т.е. H=F(N). В этом случае формула Шеннона значительно упрощается и совпадает с формулой Хартли, которая впервые была предложена американским инженером Ральфом Хартли в 1928 году, т.е. на 20 лет раньше.

Формула Шеннона имеет следующий вид:

![]() (1)

(1)

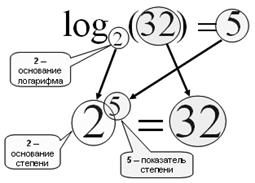

Рис. 3. Нахождение логарифма b по основанию a - это нахождение степени, в которую нужно возвести a, чтобы получить b.

Напомним, что такое логарифм.

Логарифм по основанию 2 называется двоичным:

log2 (8)=3 => 23 =8

log2 (10)=3,32 => 23,32 =10

Логарифм по основанию 10 –называется десятичным:

log10 (100)=2 => 102 =100

Основные свойства логарифма:

1. log(1)=0, т.к. любое число в нулевой степени дает 1;

2. log(ab )=b*log(a);

3. log(a*b)=log(a)+log(b);

4. log(a/b)=log(a)-log(b);

5. log(1/b)=0-log(b)=-log(b).

Знак минус в формуле (1) не означает, что энтропия – отрицательная величина. Объясняется это тем, что pi £1 по определению, а логарифм числа меньшего единицы - величина отрицательная. По свойству логарифма ![]() , поэтому эту формулу можно записать и во втором варианте, без минуса перед знаком суммы.

, поэтому эту формулу можно записать и во втором варианте, без минуса перед знаком суммы.

![]() интерпретируется как частное количество информации

интерпретируется как частное количество информации![]() , получаемое в случае реализации i-ого варианта. Энтропия в формуле Шеннона является средней характеристикой – математическим ожиданием распределения случайной величины {I0 , I1, … IN -1 }.

, получаемое в случае реализации i-ого варианта. Энтропия в формуле Шеннона является средней характеристикой – математическим ожиданием распределения случайной величины {I0 , I1, … IN -1 }.

Пример расчета энтропии по формуле Шеннона. Пусть в некотором учреждении состав работников распределяется так: ¾ - женщины, ¼ - мужчины. Тогда неопределенность, например, относительно того, кого вы встретите первым, зайдя в учреждение, будет рассчитана рядом действий, показанных в таблице 1.

Таблица 1.

| pi | 1/pi | Ii =log2 (1/pi ), бит | pi *log2 (1/pi ), бит | |

| Ж | 3/4 | 4/3 | log2 (4/3)=0,42 | 3/4 * 0,42=0,31 |

| М | 1/4 | 4/1 | log2 (4)=2 | 1/4 * 2=0,5 |

| å | 1 | H=0,81 бит |

Если же априори известно, что мужчин и женщин в учреждении поровну (два равновероятных варианта), то при расчете по той же формуле мы должны получить неопределенность в 1 бит. Проверка этого предположения проведена в таблице 2.

Таблица 2.

| pi | 1/pi | Ii =log2 (1/pi ), бит | pi *log2 (1/pi ), бит | |

| Ж | 1/2 | 2 | log2 (2)=1 | 1/2 * 1=1/2 |

| М | 1/2 | 2 | log2 (2)=1 | 1/2 * 1=1/2 |

| å | 1 | H=1 бит |

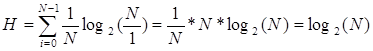

4.Формула Хартли

Формула Хартли – частный случай формулы Шеннона для равновероятных альтернатив.

Подставив в формулу (1) вместо pi его (в равновероятном случае не зависящее от i) значение ![]() , получим:

, получим:

,

,