Дипломная работа: Метод анализа главных компонентов регрессионной модели измерений средствами нейронных сетей

• Спектральная формула синтеза ковариационной матрицы по исходной реализации случайного вектора данных.

Формула синтеза исходных данных с сокращением размерности может не приниматься во внимание, так как она в основном относится к задачам распознавания образов в пространстве признаков; проблема текущей темы – расчет скалярных и векторных величин в пространстве признаков НС для решения плохо обусловленных задач регрессионного анализа.

Актуальность работы: возможность использования эффективных численных методов на алгоритмах ЭВМ при решении регрессионных методов, но в условиях дефицита априорной информации о помехах.

Целю работы является разработка технологии применения метода АГК в решении плохо обусловленных задач статического регрессионного анализа.

Основные задачи, определенные в соответствии с поставленной целью квалификационной работы:

– анализ существующих методов идентификации статических моделей статистических объектов;

– анализ основных проблем решения регрессионных задач линейными методами при дефиците априорной информации о помехах;

– изучение пространственных характеристик АГК и структур НС при обработке ими стохастических сред;

– создание на основе выявленных критериев состоятельности методов АГК описания принципов адаптации АГК к проблемам регрессионного анализа;

– модернизация классических технологий получения дисперсионных характеристик стохастических сред алгоритмами самообучения НС в пространстве признаков;

– составление алгоритмов на основе АГК, содействующие регрессионному анализу, тесты эталонных моделей с истинными параметрами;

– составление ряда рекомендаций по использованию разработанных адаптивных алгоритмов с корреляционными методами получения оценок для регрессионных моделей.

1. Организация нейронных сетей для вычисления дисперсионных характеристик случайных сигналов

1.1 Архитектура сетей

Структура нейронных сетей тесно связана с используемыми алгоритмами обучения. Классификация алгоритмов обучения будет приведена в следующей главе, а вопросы их построения будут изучены в последующих главах. В данном разделе мы сосредоточим внимание на архитектурах сетей (структурах).

В общем случае можно выделить три фундаментальных класса нейросетевых архитектур.

1.2 Однослойные сети прямого распространения

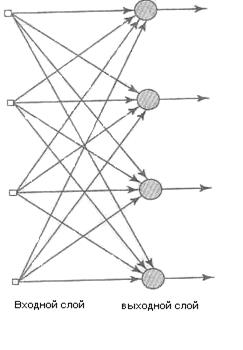

В многослойной нейронной сети нейроны располагаются по слоям. В простейшем случае в такой сети существует входной слой (inputlayer) узлов источника, информация от которого передается на выходной слой (outputlayer) нейронов (вычислительные узлы), но не наоборот. Такая сеть называется сетью прямого распространения (feedforward) или ацикличной сетью (acyclic). На рис. 1.1 показана структура такой сети для случая четырех узлов в каждом из слоев (входном и выходном). Такая нейронная сеть называется однослойной (single-layernetwork), при этом под единственным слоем подразумевается слой вычислительных элементов (нейронов). При подсчете числа слоев мы не принимаем во внимание узлы источника, так как они не выполняют никаких вычислений.

1.3 Многослойные сети прямого распространения

Другой класс нейронных сетей прямого распространения характеризуется наличием одного или нескольких скрытых слоев (biddenlayer), узлы которых называются скрытыми нейронами (hiddenneuron), или скрытыми элементами (hiddenunit). Функция последних заключается в посредничестве между внешним входным сигналом и выходом нейронной сети. Добавляя один или несколько скрытых слоев, мы можем выделить статистики высокого порядка.

Рисунок 1.1 - Сеть прямого распространения с одним слоем нейронов

Такая сеть позволяет выделять глобальные свойства данных помощью локальных соединений за счет наличия дополнительных синаптических связей и повышения уровня взаимодействия нейронов. Способность скрытых нейронов выделять статистические зависимости высокого порядка особенно существенна, когда размер входного слоя достаточно велик.

Узлы источника входного слоя сети формируют соответствующие элементы шаблона активации (входной вектор), которые составляют входной сигнал, поступающий на нейроны (вычислительные элементы) второго слоя (т.е. первого скрытого слоя). Выходные сигналы второго слоя используются в качестве входных для третьего слоя и т.д. Обычно нейроны каждого из слоев сети используют в качестве входных сигналов выходные сигналы нейронов только предыдущего слоя. Набор выходных сигналов нейронов выходного (последнего) слоя сети определяет общий отклик сети на данный входной образ, сформированный узлами источника входного (первого) слоя. Сеть, показанная на рис. 1.1, называется сетью 10-4-2, так как она имеет 10 входных, 4 скрытых и 2 выходных нейрона. В общем случае сеть прямого распространения с m входами, h1нейронами первого скрытого слоя, h2 нейронами второго скрытого слоя и qнейронами выходного слоя называется сетью m — h1— h2—q-

Нейронная сеть, показанная на рис. 1.1, считается полносвязной (fullyconnected) в том смысле, что все узлы каждого конкретного слоя соединены со всеми узлами смежных слоев. Если некоторые из синаптических связей отсутствуют, такая сеть называется неполносвязной (partiallyconnected).

1.4 Инварианты в структуре нейронной сети

Рассмотрим следующие физические явления.

• Если исследуемый объект вращается, то соответствующим образом меняется и его образ, воспринимаемый наблюдателем.

• В когерентном радаре, обеспечивающем информацию об амплитуде и фазе источников окружающей среды, эхо от движущегося объекта смещено по частоте. Это связано с эффектом Доплера, который возникает при радиальном движении объекта наблюдения относительно радара.