Реферат: Математическая теория информации

3. Для события с одним исходом количество информации равно нулю.

4. Количество информации в дискретном сообщении растет в зависимости от увеличения объема алфавита – m .

Пример 1. Определить количество информации в сообщении из 8 двоичных символов (n = 8, m = 2), если вероятности равны: pi0 = pi1 = 1/2.

Количество информации равно:

I = n log m = 8 log2 2 = 8 бит .

Пример 2. Определить количество информации в сообщении из 8 двоичных символов (n = 8, m = 2), если вероятности равны:

pi0 = 3/4; pi1 = 1/4.

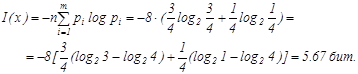

Количество информации равно:

3. Энтропия информации

Энтропия – содержательность, мера неопределенности информации.

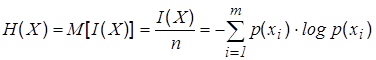

Энтропия – математическое ожидание H(x) случайной величины I(x) определенной на ансамбле {Х, р(х)} , т.е. она характеризует среднее значение количества информации, приходящееся на один символ.

. (6)

. (6)

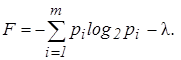

Определим максимальное значение энтропии Hmax (x) .Воспользуемся методом неопределенного множителя Лагранжа -l для отыскания условного экстремума функции [6]. Находим вспомогательную функцию:

(7)

(7)

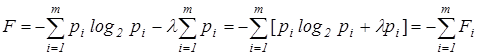

Представим вспомогательную функцию F в виде:

. (8)

. (8)

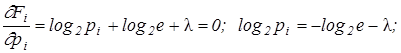

Найдем максимум этой функции

т. к.

т. к.

![]() .

.

Как видно из выражения, величина вероятности pi не зависит от i , а это может быть в случае, если все pi равны, т.е. p1 =p2 =…=pm =1/m .

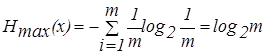

При этом выражение для энтропии равновероятных, независимых элементов равно:

. (9)

. (9)

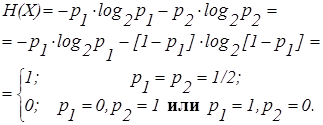

Найдем энтропию системы двух альтернативных событий с вероятностями p1 и p2 . Энтропия равна

4. Свойства энтропии сообщений

1. Энтропия есть величина вещественная, ограниченная, не отрицательная, непрерывная на интервале 0 £ p £ 1 .

2. Энтропия максимальна для равновероятных событий.

3. Энтропия для детерминированных событий равна нулю.