Реферат: Математическая теория информации

Энтропия численно совпадает со средним количеством информации но принципиально различны, так как:

H(x) – выражает среднюю неопределенность состояния источника и является его объективной характеристикой, она может быть вычислена априорно, т.е. до получения сообщения при наличии статистики сообщений.

I(x) – определяется апостериорно, т.е. после получения сообщения. С получением информации о состоянии системы энтропия снижается.

5. Избыточность сообщений

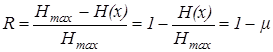

Одной из информационных характеристик источника дискретных сообщений является избыточность, которая определяет, какая доля максимально-возможной энтропии не используется источником

, (10)

, (10)

где ? – коэффициент сжатия.

Избыточность приводит к увеличению времени передачи сообщений, уменьшению скорости передачи информации, излишней загрузки канала, вместе с тем, избыточность необходима для обеспечения достоверности передаваемых данных, т.е. надежности СПД, повышения помехоустойчивости. При этом, применяя специальные коды, использующие избыточность в передаваемых сообщениях, можно обнаружить и исправить ошибки.

Пример 1. Вычислить энтропию источника, выдающего два символа 0 и 1 с вероятностями p(0) = p(1) = 1/m и определить его избыточность.

Решение: Энтропия для случая независимых, равновероятных элементов равна: H(x) = log2 m = log2 2 = 1 [дв. ед/симв.]

При этом H(x) = Hmax (x) и избыточность равна R = 0 .

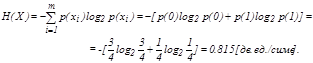

Пример 2. Вычислить энтропию источника независимых сообщений, выдающего два символа 0 и 1 с вероятностями p(0) = 3/4, p(1) = 1/4 .

Решение: Энтропия для случая независимых, не равновероятных элементов равна:

При этом избыточность равна R = 1–0,815=0,18

Пример 3. Определить количество информации и энтропию сообщения из пяти букв, если число букв в алфавите равно 32 и все сообщения равновероятные.

Решение: Общее число пятибуквенных сообщений равно: N = mn = 32

Энтропия для равновероятных сообщений равна:

H = I = – log 2 1/ N = log 2 325 = 5 log 2 32 = 25 бит./симв.

Литература

1 Гринченко А.Г. Теория информации и кодирование: Учебн. пособие. – Харьков: ХПУ, 2000.

2 Цымбал В.П. Теория информации и кодирование. – М.: Высш. шк., 1986.

3 Кловский Д.Д. Теория передачи сигналов. – М.: Связь, 1984.

4 Кудряшов Б.Д. Теория информации. Учебник для вузов Изд-во ПИТЕР, 2008. – 320 с.

5 Цымбал В.П. Теория информации и кодирование. – М.: Высш. шк., 1986.

6 Асанов М.О., Баранский В.А., Расин В.В. Дискретная математика: графы матроиды, алгоритмы. – Ижевск: НИЦ «РХД», 2001, 288 стр.