Курсовая работа: Применение методов математической статистики и теории вероятностей в задачах теоретической лингвистики при анализе устной и звучащей речи на русском и английском языках

Математическим ожиданием дискретной случайной величины Х называется сумма произведений её всех возможных значений на соответствующие вероятности, обозначается через М(Х).

Если случайная величина принимает значения ![]() , соответственно с вероятностями

, соответственно с вероятностями ![]() ,

, ![]() …

… ![]() , то

, то

Стоит заметить, что математическое ожидание является величиной постоянной, его часто называют статистическим значением случайной величины, а также центром распределения, так как около него группируются отдельные значения случайной величины.

Для «Свободного стихотворения»:

M(X)![]() = 1

= 1![]() 0.1238 + 2

0.1238 + 2![]() 0.0952 + 3

0.0952 + 3![]() 0.0762 + 4

0.0762 + 4![]() 0.1238 + 5

0.1238 + 5![]() 0.1333 +6

0.1333 +6![]() 0.1714 + 7

0.1714 + 7![]() 0.1047 + 8

0.1047 + 8![]() 0.0762 + 9

0.0762 + 9![]() 0.0476 + 10

0.0476 + 10![]() 0.0285 + 12

0.0285 + 12![]() 0.0095 + 18

0.0095 + 18![]() 0.0095 = 5.0738

0.0095 = 5.0738

Для «The Cradle Song»:

M(X)![]() = 1

= 1![]() 0.095+ 2

0.095+ 2![]() 0.1428+ 3

0.1428+ 3![]() 0.1238+ 4

0.1238+ 4![]() 0.3904+ 5

0.3904+ 5![]() 0.1333 +6

0.1333 +6![]() 0.1142+ 7

0.1142+ 7![]() 0.0857 = 4.1797

0.0857 = 4.1797

Соответственно, M(X)![]() > M(X)

> M(X)![]() , исходя из данного результата можно утверждать, что первое стихотворение сложнее для восприятия на слух, чем второе, что немаловажно для анализа звучащей речи.

, исходя из данного результата можно утверждать, что первое стихотворение сложнее для восприятия на слух, чем второе, что немаловажно для анализа звучащей речи.

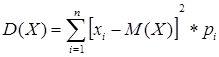

2.6 Дисперсия дискретной случайной величины

Дисперсией дискретной случайной величины Х называется математическое ожидание квадрата её отклонения от среднего статистического значения и обозначается черезD ( X ).

Для первого стихотворения:

D ( X )![]() = 0.1238(1 - 5.0738 )

= 0.1238(1 - 5.0738 )![]() + 0.0952(2 - 5.0738)

+ 0.0952(2 - 5.0738)![]() + 0.0762(3 - 5.0738)

+ 0.0762(3 - 5.0738)![]() + 0.1238(4 - 5.0738)

+ 0.1238(4 - 5.0738)![]() 0.1333(5 - 5.0738 )

0.1333(5 - 5.0738 )![]() + 0.1714(6 - 5.0738 )

+ 0.1714(6 - 5.0738 )![]() + 0.1047(7 - 5.0738)

+ 0.1047(7 - 5.0738)![]() + 0.0762(8 - 5.0738)

+ 0.0762(8 - 5.0738)![]() + 0.0476(9 - 5.0738)

+ 0.0476(9 - 5.0738)![]() + 0.0285(10 - 5.0738 )

+ 0.0285(10 - 5.0738 )![]() + 0.0095(12 - 5.0738 )

+ 0.0095(12 - 5.0738 )![]() + 0.0095(18 - 5.0738 )

+ 0.0095(18 - 5.0738 )![]() = 8.0928

= 8.0928

Для второго стихотворения:

D ( X )![]() = 0.095(1 - 4.1797)

= 0.095(1 - 4.1797)![]() + 0.1428(2 - 4.1797)

+ 0.1428(2 - 4.1797)![]() + 0.1238(3 - 4.1797)

+ 0.1238(3 - 4.1797)![]() + 0.3904(4 - 4.1797)

+ 0.3904(4 - 4.1797)![]() + 0.1333 (5 - 4.1797)

+ 0.1333 (5 - 4.1797)![]() + 0.1142(6 - 4.1797)

+ 0.1142(6 - 4.1797)![]() + 0.0857(7 - 4.1797)

+ 0.0857(7 - 4.1797)![]() = 2.9732

= 2.9732

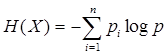

2.7 Энтропия дискретной случайной величины

Теория энтропии – основа современной теории информации, которая является актуальным направлением исследований в области теории вероятностей и высшей математики в целом. Энтропия является информационной характеристикой дискретной случайной величины. Вычисляется она по формуле К. Шеннона:

Для первого стихотворения H(X) = 3,282844098 бит

Для второго стихотворения H(X) = 2,675265 бит

Энтропия в лингвистике – это одна из наиболее универсальных теоретико-информационных характеристик текста. Это показатель сложности текста в теоретико-информационном смысле.

Из данных результатов несложно сделать вывод, что стиль и звучание «Свободного стихотворения» Зинаиды Гиппиус намного сложнее стихотворения «TheCradleSong». Оно более вариативно и несколько труднее воспринимается на слух.

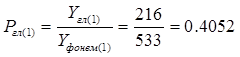

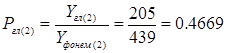

2.8 Вероятность появления гласных звуков в стихотворениях, сравнение

Рассчитать вероятность гласных звуков в стихотворении будет не сложно, тем не менее, результаты данного исследования дадут нам возможность сравнить стихотворения по уровню их певучести, плавности.

Обозначим количество гласных звуков в первом стихотворении ![]() , во втором -

, во втором - ![]()

По результатам подсчётов ![]() =216,

=216, ![]() = 205, но это ещё не значит, что русское стихотворение певучей английского, для этого следует рассчитать вероятности

= 205, но это ещё не значит, что русское стихотворение певучей английского, для этого следует рассчитать вероятности ![]() и

и ![]() по общей формуле

по общей формуле

![]() 533 – для первого стихотворения, соответственно

533 – для первого стихотворения, соответственно ![]() 439

439