Курсовая работа: Расчет информационных характеристик источников сообщений, сигналов и каналов

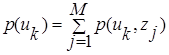

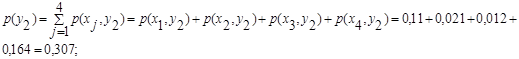

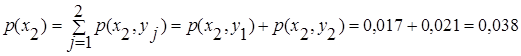

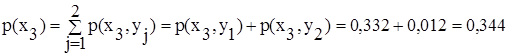

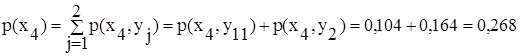

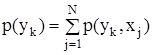

находятся безусловные вероятности p ( xk ) и p ( yk ) , которые потребуются при дальнейшем решении:

![]() ;

;

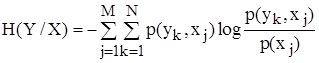

![]() ;

;

;

;

;

;

.

.

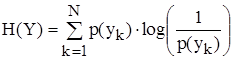

2) По формуле определения энтропии ( 1.4) , находятся энтропии ансамблей H ( X ) и H ( Y ) :

![]()

![]()

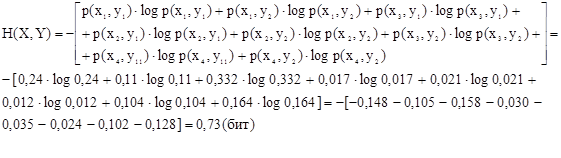

3) Для нахождения среднего количества информации, даваемое сообщением X при условии, что сообщение ансамбля Y уже известно, т.е. нахождение энтропии ансамбля H ( X , Y ) , используется формула определения энтропии объединённого ансамбля:

![]()

т.о., в нашем случае H ( X , Y ) будет равна

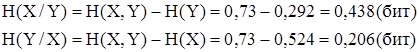

4) Итак, была найдена энтропия объединённого ансамбля. Далее по заданию требуется определить условные энтропии ансамблей H ( X / Y ) и H ( Y / X ). Формулу условной энтропии можно получить из формулы количества информации, содержащейся Y относительно X и наоборот.

1.2 Задача № 1.66

Принимаемый сигнал может иметь амплитуду ![]() (событие

(событие ![]() ) или

) или ![]() (событие

(событие ![]() ), а также сдвиг фазы

), а также сдвиг фазы ![]() (событие

(событие ![]() ) или

) или ![]() (событие

(событие ![]() ) режимах. Вероятности совместных событий имеют следующие значения:

) режимах. Вероятности совместных событий имеют следующие значения:

![]() ;

; ![]() ;

; ![]() ;

;![]() .

.

Вычислить количество информации получаемой о фазовом сдвиге сигнала, если станет известной его амплитуда.

Решение:

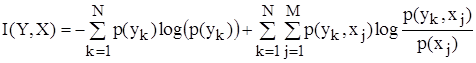

Количество информации вычисляется по формуле:

![]()

Величина I(Y,X) показывает, сколько в среднем бит информации о реализации ансамбля Y дает наблюдение реализации ансамбля Z. Подставив в эту формулу в выражение для вычисления энтропии и условной энтропии:

Учитывая, что

,

,