Реферат: Теоретические основы и методы системного анализа оптимизации управления принятия решений и

![]() - 0,1. Р1 + 0. Р2 + 0. Р3 + 0. Р4 = 0

- 0,1. Р1 + 0. Р2 + 0. Р3 + 0. Р4 = 0

0. Р1 + 0,2. Р2 – 0,3. Р3 + 0. Р4 = 0

0. Р1 + 0. Р2 + 0,3. Р3 – 0,9. Р4 = 0

1. Р1 + 1. Р2 + 1. Р3 + 1. Р4 = 1.

Решение полученной системы: Р1 = 0,32, Р2 = 0,36, Р3 = 0,24, Р4 = 0,08.

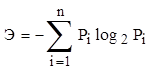

Расчет энтропий ведется по формуле

.

.

Для исходного состояния

Э0 = -4 . 0,25 . log2 0,25 = 2,

Для конечного состояния

Эк = - (0,32 . log2 0,32 + 0,36 . log2 0,36 + 0,24 . log2 0,24 + 0,08 . log2 0,08) = 1,835.

То есть, изменение энтропии составляет

DЭ = Э0 – Эк = 2 – 1,835 = 0,165.

Существуют два основных подхода к расчету энтропий систем и ценности информации.

Первый подход основан на декомпозиции исходной задачи на этапы вычисления вероятностей апостериорной и априорной вероятности элементарных событий.

Методика расчета включает:

· декомпозицию исходной задачи на последовательность таких элементарных событий, априорная вероятность которых известна, а апостериорная может быть легко рассчитана;

· расчет энтропий (или ценности информации) каждого элементарного события;

· вычисление изменения энтропии исходного состояния по отношению к конечному (или ценности информации) путем суммирования изменений энтропий элементарных этапов (переходов, событий).

Данный подход позволяет избежать вычисление вероятности сложных событий.

Второй подход основывается на использовании условных вероятностей событий. Последние иногда рассчитать довольно сложно.

Таким образом, энтропия выступает в качестве меры хаоса, беспорядка и ее снижение означает увеличение организации.

Для информационных систем степень организации очень часто зависит от количества информации, которая может быть использована для управления.

1.2 Количество информации

В теории информации количество информации часто измеряют в битах (binarydigital), где бит, определяется как ценность I информации об исходе двух равновероятных событий. Например, эта информация о том, что сейчас день, а не ночь.

Вероятность каждого из событий

Р(Д) = 0,5; Р(Н) = 0,5;

I = log2 , (1.5)

, (1.5)

где Р1 (х) – апостериорная вероятность; Р2 (х) – априорная вероятность.