Учебное пособие: Расчет информационных характеристик дискретного канала

Сумма вероятностей каждой строки равна 1,00.

Время передачи символа τ = 0,0002 сек. Передано 250 символов.

Безусловные вероятности появления символов на выходе:

p(a1 )=0.25, p(a2 )=0.35, p(a3 )=0.15, p(a4 )=0.25

2. Расчёты

1) Количество информации I(ai )каждого символа a1 , a2 , a3 дискретного сообщения :

![]() (i=1,2,3) [ бит]

(i=1,2,3) [ бит]

![]() [бит]

[бит]

![]() [бит]

[бит]

![]() [бит]

[бит]

![]() [бит]

[бит]

2)Среднее количество информации, переданное одним символом определяет энтропия источника сообщений Н(А):

![]() [бит/символ]

[бит/символ]

H(A) = -(0,25*(-2) + 0,35*(-1,51) + 0,15*(-2,73) + 0,25*(-2) = -(-0,5 - 0,53 – 0,41 – 0,5) = 1,94 [бит/символ]

3)Максимальная энтропия источника сообщений Hmax (A)

Hmax (A)= log N=log 4=2 [бит/символ]

где N-количество символов в алфавите сообщения.

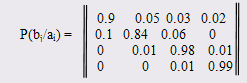

4)Информационные потери при передаче каждого символа ai определяет частная условная энтропия H(B/ai ):

![]() [бит/символ]

[бит/символ]

H(B/a1 )= -(0,9*(-0,15) + 0,05*(-4,32) + 0,03*(-5,05)+0,02*(-5,64) =

-(-0,1368 – 0,2161 – 0,1518 – 0,1129) = 0,6175 [бит/символ]

H(B/a2 )= -(0,1*(-3,32) + 0,84*(-0,25) + 0,06*(-4,05)+0) =

-(-0,3321 – 0,2112 – 0,2435 – 0) = 0,787 [бит/символ]

H(B/a3 )= -(0 + 0,01*(-6,64) + 0,98*(-0,03)+0,01*(-6,64)) =

-(-0 – 0,0664 – 0,0286 – 0,0664) = 0,1614 [бит/символ]

H(B/a4 )= -(0 + 0 + 0,01*(-6,64)+0,99*(-0,0145)) =

-(-0– 0 – 0,0664 – 0,0144) = 0,081[бит/символ]

5)Средние потери информации при передаче одного символа определяет общая условная энтропия источника Н(B/А):