Дипломная работа: Статистичний аналіз тенденцій захворюваності в Україні

РОЗДІЛ 1. ЛІНІЙНА РЕГРЕСІЯ

1.1 Метод найменших квадратів. Властивості оцінок найменших квадратів. Оцінювання σ2 . Теорія розподілів. Оцінювання при наявності лінійних обмежень

Нехай Y - випадкова величина, яка флуктуює навколо деякого невідомого параметра η, тобто Y = η + ε, де ε - флюктуація або „помилка". Наприклад, ε може бути „природною" флуктуацією, яка властива самому експерименту, або може бути помилкою у вимірюванні значення η.

Припустимо, що η можна подати у вигляді

η = β0 + β1 x1 + … + βp -1 xp -1 ,

де х1 , х2 , ..., xp -1 - відомі постійні величини, а βj (j = 0, 1, .., p - 1) - невідомі параметри, які підлягають оцінюванню. Якщо значення хj , j = 0, 1, .., p – 1 змінюються і при цьому спостерігається n значень Y1 , Y2 , ...,Yn змінною Y, то

Yi = β0 + β1 xi 1 + … + βp -1 x i , p -1 + εi , i = 1, 2, ..., n, (1.1.1)

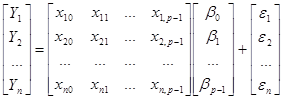

де xij i-те значенням для хj . В матричному вигляді (1.1.1) запишеться

або

Y = Xβ + ε, (1.1.2)

де x10 = x20 = ... = xn 0 = 1.

Означення. Матриця X = Х( n ![]() p ) називається регресійною матрицею. При цьому значення xij зазвичай вибираються так, щоб стовпці цієї матриці були лінійно незалежними, тобто ранг матриці X дорівнював р. Проте в деяких випадках при плануванні експерименту елементи матриці X обираються рівними тільки нулю і одиниці, і її стовпці можуть виявитися лінійно залежними. В цьому випадку матрицю X називають матрицею плану.

p ) називається регресійною матрицею. При цьому значення xij зазвичай вибираються так, щоб стовпці цієї матриці були лінійно незалежними, тобто ранг матриці X дорівнював р. Проте в деяких випадках при плануванні експерименту елементи матриці X обираються рівними тільки нулю і одиниці, і її стовпці можуть виявитися лінійно залежними. В цьому випадку матрицю X називають матрицею плану.

Далі хj називатимемо регресором, а Y – відкликом.

Модель (1.1.1) або (1.1.2) лінійна по відношенню до невідомих параметрів βj , тому її називають лінійною моделлю.

Одним з методів знаходження оцінки вектора β є метод найменших квадратів. Цей метод полягає в мінімізації суми ![]() по відношенню до вектора β. Точніше, вважаючи θ = Xβ, мінімізуємо величину ε'ε = ||Y- θ||2 по відношенню до θ

по відношенню до вектора β. Точніше, вважаючи θ = Xβ, мінімізуємо величину ε'ε = ||Y- θ||2 по відношенню до θ ![]()

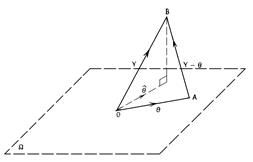

![]() [Х] = Ω, де Ω - образ оператора X, тобто Ω = {у: у = Хх} для деякого х. Якщо змінювати значення вектора θ в межах Ω, то ||Y- θ||2 (квадрат довжини вектора Y- θ) досягає мінімуму при тому значенні θ =

[Х] = Ω, де Ω - образ оператора X, тобто Ω = {у: у = Хх} для деякого х. Якщо змінювати значення вектора θ в межах Ω, то ||Y- θ||2 (квадрат довжини вектора Y- θ) досягає мінімуму при тому значенні θ = ![]() , для якого (Y -

, для якого (Y - ![]() )

) ![]() Ω (рис.1.1.1). Тому

Ω (рис.1.1.1). Тому

X'(Y - ![]() ) = 0,

) = 0,

Або

Х'![]() = Х'Y. (1.1.3)

= Х'Y. (1.1.3)

Вектор ![]() визначається однозначно, оскільки він є ортогональною проекцією вектора Y на Ω. Якщо тепер стовпці матриці X лінійно незалежні, то існує

визначається однозначно, оскільки він є ортогональною проекцією вектора Y на Ω. Якщо тепер стовпці матриці X лінійно незалежні, то існує

Рис. 1.1.1 Метод найменших квадратів полягає у знаходженні такої точки А, для якої відстань АВ мінімальна

єдиний вектор ![]() , для якого

, для якого ![]() = X

= X![]() . Підставлячи

. Підставлячи ![]() в (1.1.3), одержуємо нормальне рівняння

в (1.1.3), одержуємо нормальне рівняння

Х'Х![]() = Х'Y. (1.1.4)

= Х'Y. (1.1.4)

Оскільки ми припускаємо, що матриця X має ранг р, то матриця Х'Х додатньо визначена і, отже, не вироджена. Тому рівняння (1.1.4) має єдиний розв’язок, а саме

![]() = ( Х'Х)-1 Х'Y

= ( Х'Х)-1 Х'Y

Цей розв’язок називається оцінкою найменших квадратів вектора β.

Оцінку для β можна одержати й в інший спосіб.

ε'ε = (Y-Хβ)'(Y-Хβ) = Y'Y - 2β'Х'Y+ β'Х'Хβ